La Valeur Ajoutée de la Prévision

La valeur ajoutée de la prévision1 (FVA) est un outil simple pour évaluer la performance de chaque étape (et contributeur) du processus de prévision de la demande. Son objectif ultime est d’éliminer les gaspillages dans le processus de prévision en supprimant les points de contact humains (remplacements) qui n’augmentent pas la précision de la prévision. La FVA repose sur l’idée que la précision accrue de la prévision vaut la peine d’être poursuivie et qu’identifier les remplacements qui l’augmentent, et éliminer ceux qui ne le font pas, est souhaitable. Malgré des intentions positives, la FVA démontre une utilité limitée en une seule fois, et si elle est déployée de manière continue, présente une multitude d’inconvénients, notamment des hypothèses mathématiques défectueuses, des idées fausses sur la valeur intrinsèque de l’augmentation de la précision de la prévision, et l’absence d’une perspective financière robuste.

Aperçu de la Valeur Ajoutée de la Prévision

La valeur ajoutée de la prévision vise à éliminer les gaspillages et à augmenter la précision de la prévision de la demande en encourageant - et en évaluant - les contributions de plusieurs départements (y compris les équipes autres que la planification de la demande, telles que les Ventes, le Marketing, la Finance, les Opérations, etc.). En évaluant la valeur de chaque point de contact humain dans le processus de prévision, la FVA fournit aux entreprises des données exploitables sur les remplacements qui rendent la prévision moins bonne, leur offrant ainsi la possibilité d’identifier et d’éliminer les efforts et les ressources qui ne contribuent pas à une meilleure précision de la prévision.

Michael Gilliland, dont The Business Forecasting Deal a attiré l’attention du grand public sur la pratique, soutient2

“La FVA aide à garantir que toutes les ressources investies dans le processus de prévision - du matériel informatique et des logiciels au temps et à l’énergie des analystes et de la direction - améliorent la prévision. Si ces ressources ne contribuent pas à la prévision, elles peuvent être redirigées en toute sécurité vers des activités plus utiles.”

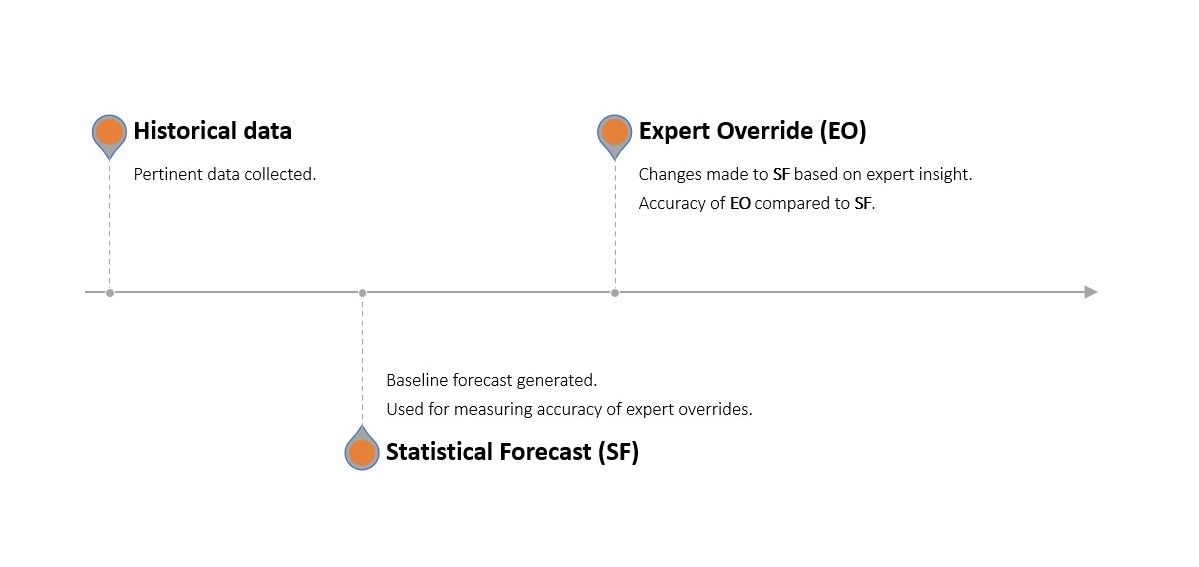

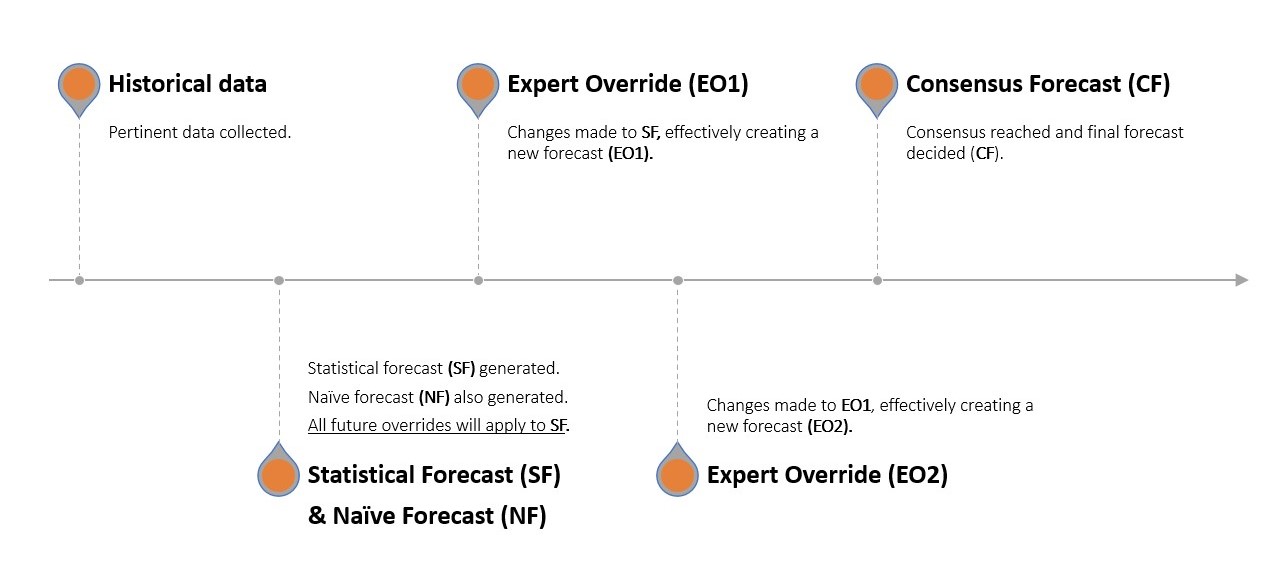

On identifie quelles activités et ressources contribuent à travers un processus de prévision multi-étapes où une prévision statistique est générée à l’aide du logiciel de prévision existant de l’entreprise. Cette prévision statistique est ensuite soumise à des modifications manuelles (remplacements) par chaque département sélectionné. Cette prévision ajustée est ensuite comparée à une prévision naïve de référence (sans modifications, agissant comme un placebo) et à la demande réelle observée.

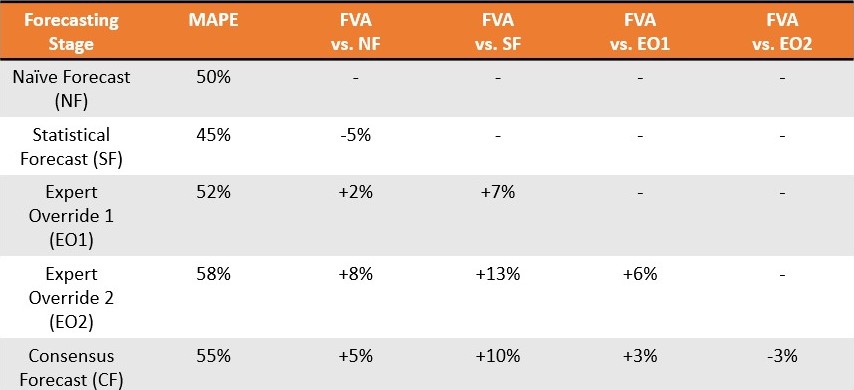

Si les modifications apportées par les départements ont rendu la prévision statistique plus précise (par rapport à la prévision statistique inchangée), elles ont apporté une valeur positive. Si elles l’ont rendue moins précise, elles ont apporté une valeur négative. De même, si la prévision statistique était plus précise que le placebo, elle ajoutait une valeur positive (et inversement si elle était moins précise).

La FVA est donc “[une mesure de] la variation d’une métrique de performance de prévision qui peut être attribuée à une étape ou un participant particulier du processus de prévision”2.

Les partisans de la valeur ajoutée de la prévision soutiennent qu’il s’agit d’un outil essentiel dans la gestion moderne de la supply chain. En identifiant quelles parties du processus de prévision sont bénéfiques et lesquelles ne le sont pas, les organisations peuvent optimiser la précision de leurs prévisions. La raison principale est que des prévisions améliorées conduisent à une meilleure gestion des stocks, une planification de production plus fluide et une allocation plus efficace des ressources.

Cela devrait donc réduire les coûts, minimiser les ruptures de stock, réduire les surstocks, tout en augmentant la satisfaction client et en générant une éthique de prévision et d’entreprise plus inclusive. Le processus s’est avéré remarquablement populaire, la FVA étant appliquée dans plusieurs entreprises de renom dans des secteurs exceptionnellement compétitifs, notamment Intel, Yokohama Tire et Nestlé3.

Réaliser une Analyse de la Valeur Ajoutée de la Prévision

Réaliser une analyse de la valeur ajoutée de la prévision implique plusieurs étapes intuitives, généralement une version proche des suivantes:

-

Définir le processus en identifiant les étapes ou composants individuels, c’est-à-dire la liste des départements qui seront consultés, l’ordre de consultation et les paramètres spécifiques que chaque contributeur utilisera pour modifier la prévision initiale.

-

Générer une prévision de référence. Cette référence prend généralement la forme d’une prévision naïve. Une prévision statistique est également générée, selon le processus de prévision normal au sein de l’entreprise, en utilisant le même ensemble de données utilisé dans la génération de la référence. Cette prévision statistique sert de base à toutes les ajustements ultérieurs.

-

Collecter les informations des contributeurs désignés, en respectant les paramètres exacts définis à la première étape. Cela peut inclure des informations sur les tendances du marché, les plans promotionnels, les contraintes opérationnelles, etc.

-

Calculer la FVA pour chaque contributeur en comparant la précision de la prévision statistique avant et après l’entrée de ce contributeur. À son tour, la précision de la prévision statistique est contrastée avec celle de la prévision de référence simple. Les contributions qui améliorent la précision de la prévision reçoivent une FVA positive, tandis que celles qui diminuent la précision reçoivent une FVA négative.

-

Optimiser en améliorant ou en éliminant les contributions avec une FVA négative, tout en préservant ou en améliorant celles avec une FVA positive.

Ces étapes forment un processus continu qui est amélioré de manière itérative dans le but d’obtenir une plus grande précision de prévision. Le processus FVA, et comment il diffère d’une prévision traditionnelle, est illustré ci-dessous.

Considérez un vendeur de pommes. Paul (Planification de la Demande) informe la direction que l’entreprise a vendu 8 pommes chacun des 3 derniers mois. La prévision naïve indique que l’entreprise vendra à nouveau 8 pommes le mois prochain, mais Paul dispose d’un logiciel statistique avancé qui prédit la vente de 10 pommes (prévision statistique). John (Marketing) intervient et dit qu’il a l’intention de sortir un nouveau slogan accrocheur ce mois-ci6 et que les ventes seront probablement plus élevées ce mois-ci grâce à son esprit vif. George (Ventes) prévoit de regrouper des pommes ensemble et de baisser légèrement les prix, stimulant ainsi les ventes et augmentant la demande. Richard (Opérations) est d’abord perplexe, mais révise ensuite la demande prévue pour refléter un arrêt imminent dans la machinerie cruciale de tri des pommes qu’il pense affectera négativement la capacité de l’entreprise à répondre à la demande. La prévision statistique a donc été ajustée manuellement trois fois. Les départements se réunissent ensuite pour parvenir verbalement à une prévision consensuelle.

Un mois plus tard, l’entreprise effectue un test rétrospectif pour confirmer à quel point le delta7 était à chaque étape de ce relais de prévision - c’est-à-dire à quel point la contribution de chaque département était “hors sujet”. Ce n’est pas difficile car ils possèdent maintenant les données de ventes réelles du mois précédent et Paul peut isoler, étape par étape, combien d’erreurs ont été introduites par John, George et Richard, respectivement, ainsi que l’étape de prévision consensuelle8.

La Perspective Mathématique sur la Valeur Ajoutée de la Prévision

En interne, la valeur ajoutée de la prévision est un processus remarquablement simple et délibérément simplifié. Contrairement aux processus de prévision qui exigent une connaissance avancée des mathématiques et du raisonnement statistique, le FVA “est une approche de bon sens facile à comprendre. Il exprime les résultats de faire quelque chose par rapport à ne rien avoir fait”3.

Exprimer les résultats d’avoir fait quelque chose par rapport à ne rien avoir fait nécessite cependant toujours une intervention mathématique, et cela prend généralement la forme d’une simple série temporelle - l’épine dorsale des méthodes traditionnelles de prévision. L’objectif principal de l’analyse des séries temporelles est de représenter de manière pratique et intuitive la demande future sous la forme d’une seule valeur exploitable. Dans le contexte du FVA, la série temporelle de référence sert de placebo ou de contrôle, par rapport auquel toutes les modifications de l’analyste (détaillées dans la section précédente) sont comparées. Une série temporelle de référence peut être générée par diverses méthodes, incluant couramment diverses formes de prévisions naïves. Celles-ci sont généralement évaluées à l’aide de métriques telles que MAPE, MAD et MFE.

Choix d’une Prévision de Référence

Le choix de la prévision de référence variera en fonction des objectifs ou des contraintes de l’entreprise en question.

-

Les Prévisions Naïves et les Prévisions Naïves Saisonnalières sont souvent choisies pour leur simplicité. Elles sont faciles à calculer et à comprendre car elles reposent sur l’hypothèse que les données précédentes se répéteront à l’avenir. Elles fournissent une base sensée dans de nombreux contextes, notamment lorsque les données sont assez stables ou semblent présenter un schéma clair (tendance, saisonnalité, etc.).

-

Les Marches Aléatoires et les Marches Aléatoires Saisonnalières sont généralement utilisées lorsque les données présentent une variabilité ou une aléatoire significative, ou lorsqu’il semble y avoir un fort schéma saisonnier soumis également à des fluctuations aléatoires. Ces modèles ajoutent un élément d’imprévisibilité au concept de prévision naïve, dans le but de refléter l’incertitude inhérente à la prévision de la demande future.

Évaluation des Résultats de la Valeur Ajoutée de la Prévision

-

Le MFE (Erreur Moyenne de Prévision) peut être utilisé pour évaluer si une prévision a tendance à surestimer ou à sous-estimer les résultats réels. Cela pourrait être une mesure utile dans une situation où il est plus coûteux de surestimer que de sous-estimer, ou vice versa.

-

Le MAD (Déviation Moyenne Absolue) et le MAPE (Erreur Moyenne en Pourcentage Absolu) fournissent des mesures de précision de la prévision qui tiennent compte à la fois de la sur- et de la sous-prévision de la demande. Ils peuvent être utilisés comme indicateurs de précision lorsqu’il est important de minimiser la taille globale des erreurs de prévision, indépendamment du fait qu’elles entraînent une sur- ou une sous-prévision.

Bien que le MAPE soit couramment présenté dans les sources liées au FVA, il existe des divergences quant à la configuration des métriques de prévision à utiliser dans une analyse FVA2 4 9.

Limitations à la FVA

La valeur ajoutée de la prévision, malgré son approche inclusive, ses nobles objectifs et sa faible barrière à l’entrée, est sans doute sujette à une vaste gamme de limitations et de fausses hypothèses. Ces lacunes couvrent un large éventail de domaines, notamment les mathématiques, la théorie moderne de la prévision et l’économie.

La prévision n’est pas collaborative

La valeur ajoutée de la prévision repose sur l’idée que la prévision collaborative est bénéfique, dans le sens où les remplacements humains multiples (et même consensuels) peuvent ajouter de la valeur positive. La FVA croit en outre que cette valeur de prévision positive est distribuée dans toute l’entreprise, car les employés de différents services peuvent tous posséder des informations précieuses sur la demande future du marché.

Ainsi, le problème tel que le voit la FVA est que cette approche collaborative est accompagnée d’inefficacités gênantes, telles que certains points de contact humains contribuant à une valeur négative. La FVA cherche donc à trier les collaborateurs inefficaces en matière de prévision à la recherche des bons.

Malheureusement, l’idée selon laquelle la prévision est meilleure en tant que processus collaboratif et multi-départemental est contraire à ce que démontre la prévision statistique moderne - y compris dans les situations de vente au détail.

Un examen approfondi de la cinquième compétition de prévision de Makridakis10 a démontré que “toutes les 50 méthodes les plus performantes étaient basées sur l’apprentissage automatique (machine learning). Par conséquent, M5 est la première compétition M dans laquelle toutes les méthodes les plus performantes étaient à la fois des méthodes d’apprentissage automatique et meilleures que tous les autres benchmarks statistiques et leurs combinaisons” (Makridakis et al., 2022)11. La compétition de précision M5 était basée sur la prévision des ventes en utilisant des données historiques pour la plus grande entreprise de vente au détail au monde en termes de revenus (Walmart).

En fait, selon Makridakis et al. (2022), “le modèle gagnant [dans le M5] a été développé par un étudiant avec peu de connaissances en prévision et peu d’expérience dans la construction de modèles de prévision des ventes”11, remettant ainsi en question la pertinence des informations sur le marché provenant de départements disparates dans un contexte de prévision.

Cela ne signifie pas que des modèles de prévision plus complexes sont nécessairement souhaitables. Au contraire, les modèles sophistiqués l’emportent souvent sur les modèles simplistes, et la prévision collaborative de la FVA est une approche simpliste à un problème complexe.

Ignore l’incertitude future

La FVA, comme de nombreux outils et techniques entourant la prévision, suppose que la connaissance du futur (dans ce cas, la demande) peut être représentée sous forme de séries temporelles. Elle utilise une prévision naïve comme référence (généralement une copie-coller des ventes précédentes) et les collaborateurs arrondissent manuellement les valeurs d’une prévision statistique. Cela est problématique pour deux raisons.

Tout d’abord, le futur, que ce soit de manière générale ou en termes de prévision, est irréductiblement incertain. Ainsi, l’exprimer sous forme de valeur unique est une approche intrinsèquement erronée (même si elle est augmentée d’une formule de stock de sécurité). Face à l’incertitude irréductible du futur, l’approche la plus sensée est de déterminer une gamme de valeurs futures probables, évaluées par rapport au retour financier potentiel de chacune. Cela l’emporte, d’un point de vue de la gestion des risques, sur le fait de tenter d’identifier une valeur unique selon une série temporelle traditionnelle - ce qui ignore complètement le problème de l’incertitude future.

Ensuite, les insights (aussi utiles qu’ils puissent sembler) des collaborateurs sont généralement du type qui n’est pas facilement (voire pas du tout) traduit en prévision de séries temporelles. Considérez une situation dans laquelle une entreprise sait à l’avance qu’un concurrent s’apprête à entrer sur le marché. Ou imaginez un monde où la connaissance concurrentielle indique que le plus féroce concurrent prévoit de sortir une nouvelle ligne impressionnante de vêtements d’été. L’idée que ces types d’insights peuvent être pliés de manière collaborative par des non-spécialistes en une seule valeur exprimée dans une série temporelle est fantaisiste.

En réalité, toute similitude avec les ventes futures réelles (valeur ajoutée positive) sera complètement accidentelle, dans le sens où les remplacements humains (qu’il s’agisse d’arrondir la demande à la hausse ou à la baisse) sont des expressions égales de la même entrée défectueuse. Une personne qui apporte une valeur négative n’est donc pas plus “juste” ou “fausse” - d’un point de vue logique - que la personne qui apporte une valeur positive.

Au fond, la FVA tente de projeter des propriétés tridimensionnelles (les insights humains) sur une surface bidimensionnelle (une série temporelle). Cela peut sembler correct d’un certain angle, mais cela ne signifie pas que cela l’est. Cela donne à la FVA une apparence plutôt trompeuse de rigueur statistique.

Même si l’entreprise utilise un processus de prévision traditionnel avec un minimum de points de contact humains (comme le montre la Figure 1), si la prévision statistique sous-jacente analysée par la FVA est une série temporelle, l’analyse elle-même est une perte de temps.

Ironiquement gaspilleur

En tant que démonstration ponctuelle de surconfiance et de biais dans la prise de décision, la FVA a son utilité. Des prix Nobel ont été décernés pour la profondeur, l’étendue et la persistance des biais cognitifs dans la prise de décision humaine12 13, mais il est tout à fait concevable que certaines équipes refusent d’accepter à quel point le remplacement humain est généralement défectueux jusqu’à ce qu’elles en soient catégoriquement convaincues.

Cependant, en tant qu’outil de gestion continu, la FVA est intrinsèquement défectueuse et probablement contradictoire. Si les prévisions statistiques sont surpassées par une prévision naïve et des ajustements collaboratifs, il convient vraiment de se poser la question suivante:

Pourquoi les modèles statistiques échouent-ils?

Malheureusement, la FVA n’a pas de réponse à cela car elle n’est fondamentalement pas conçue pour le faire. Elle ne fournit pas d’informations sur pourquoi les modèles statistiques pourraient sous-performer, simplement qu’ils sous-performent. La FVA n’est donc pas tant un outil de diagnostic qu’une loupe.

Bien qu’une loupe puisse être utile, elle ne fournit pas d’informations exploitables sur les problèmes sous-jacents du logiciel de prévision statistique. Comprendre pourquoi les prévisions statistiques sous-performent a une valeur directe et indirecte bien plus grande, et c’est quelque chose que la FVA ne met pas en lumière.

Non seulement le logiciel FVA ne fournit pas cette information importante, mais il formalise également le gaspillage de différentes manières. Gilliland (2010) présente une situation théorique dans laquelle une prévision de consensus est surpassée pendant 11 des 13 semaines (taux d’échec de 85 %), avec une moyenne de 13,8 points de pourcentage d’erreur. Plutôt que de justifier une interruption immédiate, le conseil est de

“présenter ces résultats à votre direction et essayer de comprendre pourquoi le processus de consensus a cet effet. Vous pouvez commencer à enquêter sur la dynamique de la réunion de consensus et les agendas politiques des participants. En fin de compte, la direction doit décider si le processus de consensus peut être corrigé pour améliorer la précision de la prévision, ou s’il doit être éliminé.”2

Dans ce scénario, non seulement le logiciel FVA ne diagnostique pas le problème sous-jacent de la performance de la prévision statistique, mais la couche d’instrumentation FVA ne fait qu’augmenter la bureaucratie et l’allocation des ressources en disséquant des activités qui ne contribuent manifestement pas de valeur.

Ainsi, l’installation d’une couche de logiciel FVA garantit que l’on continue à obtenir des images de basse résolution similaires d’un problème en cours et dirige des ressources précieuses vers la compréhension d’entrées défectueuses qui auraient pu être ignorées dès le départ.

Cela, de manière argumentée, n’est pas la répartition la plus judicieuse des ressources de l’entreprise qui ont d’autres utilisations possibles.

Surestime la Valeur de l’Exactitude

Au cœur de la FVA, on présume que l’augmentation de la précision des prévisions vaut la peine d’être poursuivie isolément, et procède sur cette base comme si cela était évidemment vrai. L’idée que l’augmentation de la précision des prévisions est souhaitable est compréhensible, mais - d’un point de vue commercial - cela présuppose que plus de précision se traduit par une plus grande rentabilité. Ce n’est manifestement pas le cas.

Cela ne signifie pas qu’une prévision précise n’est pas utile. Au contraire, une prévision précise devrait être étroitement liée à une perspective purement financière. Une prévision peut être 40 % plus précise mais le coût associé signifie que l’entreprise réalise 75 % de moins de profit global. La prévision, bien qu’appréciablement plus précise (valeur ajoutée positive), n’a pas réduit les dollars d’erreur. Cela va à l’encontre du principe fondamental de l’entreprise: gagner plus d’argent, ou du moins ne pas le gaspiller.

En termes de FVA, il est tout à fait concevable que la valeur ajoutée positive d’un département soit une perte nette pour une entreprise, tandis que la valeur ajoutée négative d’un autre est imperceptible. Bien que Gilliland reconnaisse que certaines activités pourraient augmenter la précision sans ajouter de valeur financière, cet angle n’est pas suivi jusqu’à son aboutissement logique: une perspective strictement financière. Gilliland utilise l’exemple d’un analyste augmentant la précision des prévisions d’un point de pourcentage:

“Le simple fait qu’une activité de processus ait une FVA positive ne signifie pas nécessairement qu’elle doit être conservée dans le processus. Nous devons comparer les avantages globaux de l’amélioration au coût de cette activité. L’exactitude supplémentaire augmente-t-elle les revenus, réduit-elle les coûts ou rend-elle les clients plus heureux? Dans cet exemple, le remplacement de l’analyste a réduit l’erreur d’un point de pourcentage. Mais devoir embaucher un analyste pour examiner chaque prévision peut être coûteux, et si l’amélioration n’est que d’un point de pourcentage, en vaut-elle vraiment la peine?”2

En d’autres termes, une augmentation de 1 % pourrait ne pas valoir la peine d’être poursuivie, mais une augmentation plus importante de la précision des prévisions pourrait l’être. Cela présuppose que la valeur financière est liée à une plus grande précision des prévisions, ce qui n’est pas nécessairement vrai.

Ainsi, il y a une dimension financière inéluctable à la prévision qui est au mieux sous-estimée dans la FVA (et, au pire, à peine remarquée). Cette perspective strictement financière devrait vraiment être la base sur laquelle un outil visant à réduire le gaspillage est construit.

Vulnérabilité à la Manipulation

La FVA présente également une opportunité évidente de manipulation et de trucage des prévisions, surtout si la précision des prévisions est utilisée comme mesure de la performance départementale. C’est l’esprit de la loi de Goodhart, qui stipule qu’une fois qu’un indicateur devient la principale mesure du succès (accidentellement ou délibérément), cet indicateur cesse d’être utile. Ce phénomène peut souvent ouvrir la porte à des interprétations erronées et/ou à la manipulation.

Supposons que l’équipe des ventes est chargée d’apporter des ajustements à court terme aux prévisions de la demande en fonction de leurs interactions avec les clients. Le département des ventes pourrait voir cela comme une opportunité de signaler sa valeur et commencer à apporter des modifications aux prévisions même lorsque ce n’est pas nécessaire, dans le but de démontrer une FVA positive. Ils pourraient surestimer la demande, ce qui les ferait apparaître comme générant de la valeur, ou recalculer la demande à la baisse, ce qui les ferait apparaître comme corrigeant une projection trop optimiste d’un département précédent. De toute façon, le département des ventes pourrait sembler plus précieux pour l’entreprise. En conséquence, le département marketing pourrait alors se sentir sous pression pour sembler générer de la valeur également, et l’équipe commence à apporter des ajustements arbitraires de manière similaire aux prévisions (et ainsi de suite).

Dans ce scénario, la mesure FVA, initialement destinée à améliorer la précision des prévisions, devient simplement un mécanisme politique pour les départements de signaler de la valeur plutôt que d’en ajouter, une critique même reconnue par les partisans de la FVA9. Ces exemples illustrent les dangers potentiels de la Loi de Goodhart en ce qui concerne la FVA14.

Les partisans de la FVA pourraient soutenir que ces critiques psychologiques sont tout l’intérêt de la FVA, à savoir l’identification des entrées précieuses par rapport aux entrées inutiles. Cependant, étant donné les biais associés à la substitution humaine dans les prévisions sont si bien compris de nos jours, les ressources consacrées à disséquer ces entrées biaisées seraient mieux allouées à un processus qui évite (autant que possible) ces entrées en premier lieu.

Solution Locale à un Problème Systémique

Implicitement, la tentative d’optimiser la prévision de la demande de manière isolée présuppose que le problème de la prévision de la demande est distinct des autres problèmes de la supply chain. En réalité, la prévision de la demande est complexe en raison de l’interaction d’un large éventail de causes systémiques de la supply chain, y compris l’influence des délais de livraison variables des fournisseurs, les perturbations inattendues de la supply chain, les choix d’allocation des stocks, les stratégies de tarification, etc.

Tenter d’optimiser la prévision de la demande de manière isolée (alias, optimisation locale) est une approche erronée étant donné que les problèmes au niveau du système - les véritables causes profondes - ne sont pas correctement comprises et traitées.

Les problèmes de la supply chain - dont la prévision de la demande en fait certainement partie - sont comme des personnes debout sur un trampoline : déplacer une personne crée un déséquilibre pour tout le monde15. Pour cette raison, une optimisation holistique de bout en bout est préférable à la tentative de traiter les symptômes de manière isolée.

L’avis de Lokad

La valeur ajoutée des prévisions prend une mauvaise idée (les prévisions collaboratives) et la rend sophistiquée, habillant la mauvaise idée de couches de logiciels inutiles et gaspillant des ressources qui pourraient avoir de meilleures utilisations alternatives.

Une stratégie plus sophistiquée consisterait à regarder au-delà du concept même de précision des prévisions et à opter plutôt pour une politique de gestion des risques qui réduit les dollars d’erreur. En conjonction avec une approche de prévision probabiliste, cette mentalité s’éloigne des KPI arbitraires - tels que l’augmentation de la précision des prévisions - et intègre la totalité des leviers économiques, des contraintes et des chocs potentiels de la supply chain dans la prise de décision en matière de stocks. Ces types de vecteurs de risque (et de gaspillage) ne peuvent pas être efficacement quantifiés (et éliminés) par un outil qui exploite une perspective collaborative et temporelle, comme celle trouvée dans la valeur ajoutée des prévisions.

De plus, en séparant la prévision de la demande de l’optimisation globale de la supply chain, la FVA (peut-être involontairement) augmente la complexité accidentelle du processus de prévision de la demande. La complexité accidentelle est synthétique et résulte de l’accumulation progressive de bruit inutile - généralement d’origine humaine - dans un processus. Ajouter des étapes redondantes et des logiciels au processus de prévision, comme le fait la FVA, est un exemple typique de complexité accidentelle et peut rendre le problème à résoudre significativement plus complexe.

La prévision de la demande est un problème intentionnellement complexe, ce qui signifie qu’il s’agit d’une tâche intrinsèquement déroutante et gourmande en ressources. Cette complexité est une caractéristique immuable du problème et représente une classe de défi beaucoup plus préoccupante que les problèmes accidentellement complexes. Pour cette raison, il est préférable d’éviter les tentatives de solutions qui simplifient à l’excès et déforment fondamentalement le problème à résoudre16. Pour reprendre la rhétorique médicale de la littérature sur la FVA, c’est la différence entre guérir une maladie sous-jacente et traiter constamment les symptômes au fur et à mesure de leur apparition17.

En bref, la FVA se situe entre la théorie de pointe de la supply chain et la prise de conscience du public à ce sujet. Il est recommandé de mieux éduquer sur les causes sous-jacentes de l’incertitude de la demande - et ses racines dans l’évolution de la discipline de la supply chain.

Notes

-

Forecast Value Added et Forecast Value Add sont utilisés pour désigner le même outil d’analyse des prévisions. Bien que les deux termes soient largement utilisés, il existe une préférence négligeable en Amérique du Nord pour le second (selon Google Trends). Cependant, Michael Gilliland l’a explicitement désigné sous le nom de Forecast Value Added tout au long de The Business Forecasting Deal - le livre (et l’auteur) le plus souvent cité dans les discussions sur la FVA. ↩︎

-

Gilliland, M. (2010). The Business Forecasting Deal, Wiley. ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

-

Gilliland, M. (2015). Forecast Value Added Analysis: Step by Step, SAS. ↩︎ ↩︎ ↩︎

-

Chybalski, F. (2017). Forecast value added (FVA) analysis as a means to improve the efficiency of a forecasting process, Operations Research and Decisions. ↩︎ ↩︎

-

Le tableau du modèle a été adapté de Schubert, S., & Rickard, R. (2011). Using forecast value added analysis for data-driven forecasting improvement. IBF Best Practices Conference. Le rapport en escalier apparaît également dans le livre de Gilliland, The Business Deal. ↩︎

-

John a opté pour “Tout ce dont vous avez besoin, ce sont des pommes” plutôt que le légèrement plus verbeux “Nous pouvons arranger ça… avec des pommes”. ↩︎

-

Dans le contexte actuel, delta est une mesure de la quantité d’erreur introduite dans la prévision par chaque membre du processus de prévision. Cette utilisation du terme diffère légèrement de delta dans le trading d’options, qui mesure le taux de variation du prix d’une option par rapport au prix d’un actif sous-jacent. Les deux sont des expressions globales de la volatilité, mais le diable se cache dans les détails. ↩︎

-

Le lecteur est invité à remplacer la demande de pommes en prévision de la demande pour un vaste réseau mondial de magasins, à la fois en ligne et hors ligne, tous possédant un catalogue avec 50 000 SKU. La difficulté, sans surprise, augmente de manière exponentielle. ↩︎

-

Vandeput, N. (2021). Valeur Ajoutée de la Prévision, Medium. ↩︎ ↩︎

-

Les compétitions de prévision de Spyros Makridakis, connues familièrement sous le nom de M-compétitions, ont lieu depuis 1982 et sont considérées comme l’autorité principale en matière de méthodologies de prévision de pointe (et parfois saignantes). ↩︎

-

Makridakis, S., Spiliotis, E., & Assimakopolos, V., (2022). Compétition de Précision M5 : Résultats, Constatations et Conclusions. Il convient de mentionner que tous les 50 meilleures méthodes n’étaient pas basées sur l’apprentissage automatique. Il y avait une exception notable… Lokad. ↩︎ ↩︎

-

Le travail (à la fois individuellement et collectivement) de Daniel Kahneman, Amos Tversky et Paul Slovic représente un exemple rare de recherche scientifique de référence obtenant une reconnaissance grand public. Le livre de Kahneman de 2011 Réfléchir, vite et lentement - qui détaille une grande partie de sa recherche primée par le prix Nobel de 2002 - est un texte de référence dans l’écriture scientifique populaire et couvre les biais dans la prise de décision dans une mesure dépassant le cadre de cet article. ↩︎

-

Karelse, J. (2022), Histoires du Futur, Forbes Books. Karelse consacre un chapitre entier à la discussion des biais cognitifs dans un contexte de prévision. ↩︎

-

C’est un point non trivial. Les départements ont généralement des KPI qu’ils doivent atteindre, et la tentation de manipuler les prévisions pour servir leurs propres besoins est à la fois compréhensible et prévisible (jeu de mots intentionnel). Pour information, Vandeput (2021, précédemment cité) observe que la haute direction - dernière étape du carrousel FVA - peut délibérément fausser la prévision pour satisfaire les actionnaires et/ou les membres du conseil d’administration. ↩︎

-

Cette analogie est empruntée à la psychologue Carol Gilligan. Gilligan l’a initialement utilisée dans le contexte du développement moral des enfants et de l’interrelation de l’action humaine. ↩︎

-

Il est intéressant de souligner ici. Solution(s) est quelque peu inapproprié dans le contexte de la complexité intentionnelle. Compromis - disponibles en versions meilleure ou pire - refléterait mieux l’équilibre délicat associé à la résolution de problèmes intentionnellement complexes. On ne peut vraiment pas résoudre un problème où deux valeurs ou plus sont en opposition totale. Un exemple est la lutte entre la réduction des coûts et l’atteinte de niveaux de service plus élevés. Étant donné que l’avenir est irréductiblement incertain, il n’y a aucun moyen de prédire la demande avec une précision de 100%. On peut cependant atteindre un niveau de service de 100% - si c’est la principale préoccupation de l’entreprise - simplement en stockant beaucoup plus de stocks que ce que l’on pourrait jamais vendre. Cela entraînerait des pertes énormes, ainsi les entreprises, implicitement ou non, acceptent qu’il y ait un compromis inévitable entre les ressources et le niveau de service. En tant que tel, le terme “solution” cadre incorrectement le problème comme étant capable d’être résolu plutôt que atténué. Voir Économie de Base de Thomas Sowell pour une analyse approfondie de la lutte entre des compromis rivaux. ↩︎

-

Dans The Business Forecasting Deal, Gilliland compare FVA à un essai clinique avec des prévisions naïves agissant comme un placebo. ↩︎